ChallengeDans le cadre de l’atelier, nous proposons un challenge d’évaluation de LLM par la tâche. Il s’agit d’extraction d’information en français dans un contexte few-shot où seuls seront donnés le guide d’annotation décrivant les classes d’entités et leurs conventions d’annotation et quelques documents annotés. Les participants sont invités à évaluer les mises-en-œuvre par des LLM mais la participation avec d’autres approches est bienvenue et permettra de mettre en perspective les résultats des systèmes fondés sur les LLM. Les participants seront invités à présenter leurs travaux dans un bref article et le jour de l’atelier. Dscription des données

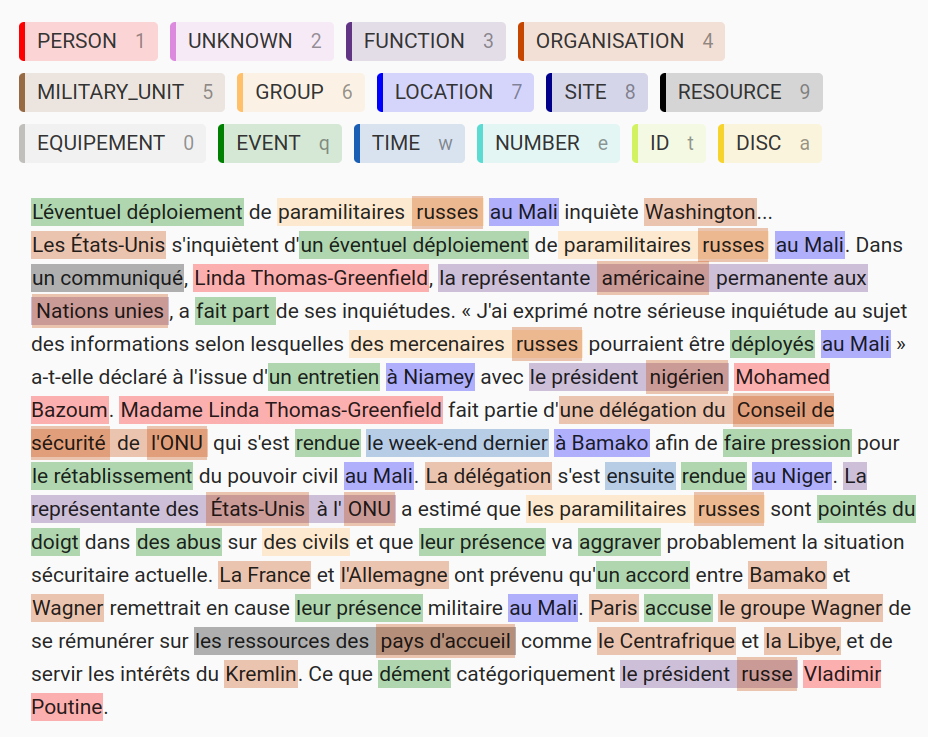

Le guide d'annotation est celui fourni à des annotateurs humains. Il donne les règles générales d'annotation, et pour chaque catégorie, il précise la définition de cette catégorie et fournit quelques exemples.

Conditions de participationLes données (guide et exemples) sont fournies aux participants sous signature d’un accord d’utilisation des données à renvoyer complété (PDF) à : dga-mi-event-tal.contact.fct@intradef.gouv.fr La récupération des données engage moralement l'équipe à participer (soumettre des résultats, un rapport de participation, et autant que possible participer à l'atelier). Il est demandé aux équipes participantes de :

À l’issue de la phase d’entrainement, les données de test seront mises à disposition des participants pendant 3 jours (à choisir dans un intervalle de 3 semaines) et les résultats leur seront ensuite communiqués. Calendrier du challengeinscription et récupération des données : jusqu'à période de test période de test : 3 jours consécutifs à choisir entre le 13 mai et le 31 mai soumission de l'article (rapport de participation) : 14 juin via la page de soumission version finale de l'article (rapport de participation) : 21 juin

Soumission des runs et métriques Trois runs par équipe peuvent être soumis, par mail à dga-mi-event-tal.contact.fct@intradef.gouv.fr Format de sortie attendu en JSON : identique aux fichiers de train fournis. Métriques : micro et macro précision, rappel et f1-mesure en considérant toutes les entités sauf l'entité EVENT + précision, rappel et f1-mesure par entité.

|